Désindexer des url : Guide complet pour une désindexation efficace

Clément Poletti

Le contrôle des contenus indexés est primordial pour le bon référencement de votre site. Pourquoi et comment désindexer certaines urlUniform Resource Locator. Adresse unique d'une page web. Une URL optimisée est courte, descriptive et contient le mot-clé. peut-il améliorer la visibilité de ce dernier ? Avant de nous plonger dans les méthodes, commençons par comprendre un élément essentiel : c'est quoi l'URL d'un site ?

C'est quoi l'URL d'un site ?

L’url (Uniform Resource Locator) représente l’adresse d’une page d’un site web. Elle permet de localiser une page parmi toutes les autres prAlgorithme historique de Google évaluant l'importance d'une page selon ses backlinks. Toujours utilisé en interne.ésentes sur internet.

Elle est composée de cinq composants essentiels :

- Le protocole : la façon dont les utilisateurs peuvent accéder aux pages de votre site internet est décrite dans le protocole. Les plus courants sont https, http et ftp.

- Le sous-domaine indique quelle section particulière de votre site doit être affichée.

- Le nom de domaine principal de votre site Web permet aux visiteurs de savoir de quoi il parle. Sur notre site, il s'agit de slashr.fr.

- Le répertoire indique la section particulière du site sur laquelle se trouve l'utilisateur. Il est sous la forme "/répertoire".

Votre visibilité sur Internet dépend de votre url. Elle permet aux moteurs de recherche d'identifier très précisément le contenu d'une page internet.

Pour y parvenir, il est nécessaire d'intégrer les informations spécifiques à une page, notamment ses mots clés, à l'url.

Si l'on considère que l'url est l'adresse de la maison, l'extension donne directement accès à la pièce de la maison.

Besoin d'aide pour désindexer des pages en masse ? Faites appel à une agence de référencement naturel technique comme Slashr.

Pourquoi est-il important de désindexer ?

Parfois, du contenu confidentiel est indexé à votre insu depuis votre site ou même le site d’un de vos partenaires. Dans ce cas, il est préférable de retirer de l’index ces contenus indésirables.

La suppression de l'index est une technique SEOSearch Engine Optimization. Ensemble des techniques visant à améliorer le positionnement d'un site web dans les résultats naturels des moteurs de recherche. qui consiste à retirer des pages d'un site web de l'index des moteurs de recherche.

Elle optimise l'expérience utilisateurUser Experience. Qualité de l'expérience vécue par un utilisateur sur un site. Facteur de ranking indirect. en empêchant le contenu de faible qualité d'apparaître dans les résultats de recherche.

Cet algorithmeProgramme informatique utilisé par les moteurs de recherche pour classer les pages web. Google utilise plus de 200 facteurs de ranking. pénalise les sites qui ont des pages sans valeur. Les contenus de mauvaise qualité sont souvent la cause.

Parmi les pages indésirables les plus souvent indexées, on retrouve le plus souvent :

- Les pages de résultats internes

- Les pages dupliquées

- Les contenus obsolètes

Vous souhaitez au contraire bien vous positionner ? Découvrez notre article sur le positionnement Google.

Méthodes de désindexation

Utilisation de la balise "noindex"

Il existe deux méthodes pour utiliser la règle noindexDirective indiquant aux moteurs de ne pas indexer une page. :

- La balise <meta>.

- La réponse HTTP.

Vous pouvez également utiliser “noindex” avec d'autres règles. Par exemple, vous pouvez connecter un indicateur nofollowAttribut indiquant aux moteurs de ne pas suivre un lien ou de ne pas transmettre de jus SEO. à une règle noindex afin de bloquer le crawl :

<meta charset="utf-8" content="noindex, nofollow"/>

Placez la balise suivante dans la section <head> pour empêcher l'indexationProcessus par lequel Google ajoute une page à sa base de données pour qu'elle puisse apparaître dans les résultats. d'une page par tous les moteurs de recherche :

<meta charset="utf-8" content="noindex">

Utilisez la balise ci-dessous pour bloquer uniquement les robots Google :

<!-meta name="googlebotRobot d'exploration de Google qui parcourt le web pour découvrir et indexer les pages." content="noindex"-->

Il est important de comprendre que certains moteurs de recherche peuvent interpréter différemment la règle noindex. Par conséquent, votre page sera toujours présente dans leurs résultats.

Désindexer avec l'en-tête HTTP

L'en-tête HTTP X-Robots-Tag avec une valeur “noindex” ou “none” peut être utilisé à la place d'une balise <meta> pour empêcher l'indexation des ressources non HTML comme les fichiers PDF, vidéo et image.

Pour y parvenir, veuillez intégrer ce code dans le fichier .htaccess à la racine du site :

HTTP/1.1 200 OK

(...)

X-Robots-Tag: noindex

(...)

Les pages web ne sont pas désindexées immédiatement après leur suppression.

Utilisez les codes 404Code HTTP indiquant qu'une page n'existe pas. Trop d'erreurs 404 nuisent au crawl budget. ou 410 pour confirmer la suppression à Google de son index. Utilisez la balise canonicalBalise indiquant la version principale d'une page en cas de contenu dupliqué ou similaire. pour éviter les sanctions pour du contenu dupliqué.

Chaque page dupliquée contient une balise dans la section <head> qui indique à Google de ne considérer que la page principale, dont l'url est indiquée dans la balise.

Désindexer via le Robots.txt

Afin d’optimiser au mieux son budget de crawl, un fichier robots.txt dirige les robots de recherche des moteurs de recherche vers les url accessibles de votre site. Vous pouvez les diriger grâce à la fonction allow et disallow.

Cependant, il ne sert pas à empêcher une page Web d'apparaître dans les résultats de recherche Google. En effet, il va avant tout empêcher les robots d’indexation de crawler certaines pages, mais si ces dernières ont été indexées au préalable et que vous recourez à cette méthode, elles ne seront pas désindexées du moment que les robots ne verront pas le “noindex” dans le code source des pages.

Si vous avez commis cette erreur, veuillez suivre les étapes suivantes :

- Ajustez votre robots.txtFichier texte à la racine d'un site indiquant aux robots quelles pages explorer ou ignorer. afin qu’il allow la page en question

- Attendez que la page soit désindexée

- Remettez en place le disallow

II a en revanche certaines limites. Cela ne fonctionne pas avec tous les moteurs de recherche. Tous les robots d'explorationProcessus par lequel les robots des moteurs de recherche parcourent et analysent les pages web. ne respectent pas les instructions. Si une page est référencée ailleurs, elle peut également y être indexée.

Désindexer rapidement une page sur Google

Utilisation de Google SafeSearch

Les propriétaires de sites Web peuvent gérer temporairement l'apparition de leurs url dans les résultats de recherche Google avec l'outil de suppression Google SafeSearch, accessible via la Search Console.

L’outil de Google permet notamment de bloquer temporairement des url particulières et de vérifier l'historique des demandes de suppression.

Il est utile afin de supprimer rapidement une url de l'index de Google ou mettre à jour les résultats lorsque le contenu a été modifié. Il ne garantit malheureusement pas la suppression définitive de l'url ou du contenu.

Il est par ailleurs possible de supprimer du contenu de votre site et de vous assurer que votre serveur web affiche un code d'état HTTP 404 (Introuvable) ou 410 (Déplacé) pour désindexer une url de manière permanente.

Comment pousser Google à re-crawler une page?

Il existe deux méthodes adéquates pour accélérer la désindexation de vos url sur Google :

- Utilisez l'outil d'inspection des url de Google Search Console pour examiner les url spécifiques. Notez que les demandes répétées n'accélèrent pas le processus et que vous êtes limité à un certain quota pour l'envoi d'url individuelles.

- Utilisez un sitemapFichier XML listant toutes les URLs d'un site pour faciliter leur découverte par les moteurs de recherche. pour un grand nombre d'url. Il aide Google à trouver les url qui doivent être désindexées.

Cependant, ces demandes ne vous garantissent pas une désindexation instantanée. En effet, ça peut prendre plusieurs jours ou semaines. Néanmoins, par rapport à l'attente passive du crawler de Google, ces techniques peuvent accélérer le processus de désindexation.

Comment éviter et corriger les erreurs courantes de désindexation

Précautions à prendre lors de la désindexation d'une url

Avant de procéder à la désindexation d'une url sur votre site, il est essentiel de peser les conséquences. En effet, assurez-vous que la page n'a pas de valeur pour le référencement SEO ou de liens de qualité.

Lors de l'utilisation de la balise "noindex", vérifiez que votre fichier robots.txt ne bloque pas l'accès aux pages concernées.

De plus, soyez conscient que la désindexation n'est pas immédiate, cela peut prendre un certain temps avant que les robots visitent votre site.

Si vous utilisez l'en-tête HTTP X-Robots-Tag pour désindexer des fichiers sans code source, faites-le avec prudence, car une mauvaise manipulation peut causer de gros problèmes d’indexation sur votre site.

Exemples d'erreurs courantes et comment les corriger

- Désindexation involontaire : Parfois, une page peut être désindexée par erreur. Pour corriger cela, assurez-vous d’avoir bien respecté les informations précédentes.

- Utiliser robots.txt pour désindexer n’est pas possible, car il empêche seulement le crawl.

-> Découvrez Slashr, la meilleure agence SEO sur Lille !

Comment Vérifier la Désindexation d'une url?

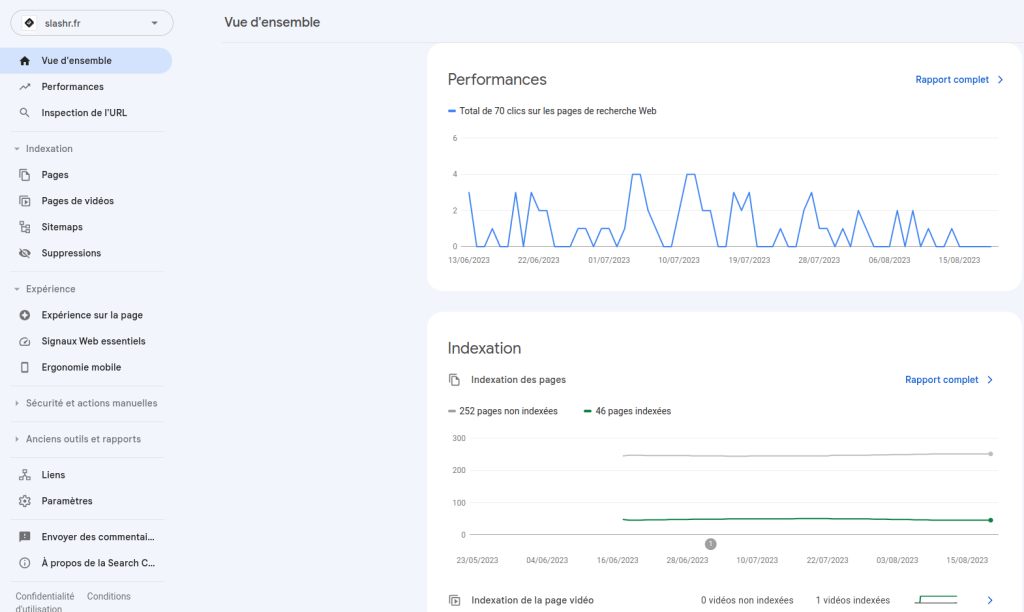

Pour vérifier si une url a bien été désindexée, vous pouvez utiliser Google Search ConsoleOutil gratuit Google pour surveiller et optimiser la présence d'un site dans les résultats de recherche.. Une fois dedans, utilisez l'outil d'inspection des url pour examiner l'url spécifique. Cela vous montrera si l'url est sur l'index Google.

Il vous est également possible d’effectuer une recherche sur Google en utilisant la requêteTerme ou expression que les utilisateurs saisissent dans un moteur de recherche. Base de toute stratégie SEO. "site:monsite.fr/ma-page". Si la page n'apparaît pas dans les résultats, c’est qu’elle a bien été désindexée.

Tags

Clément Poletti

Expert SEO @ SLASHR

Passionné par le référencement naturel et les stratégies de croissance organique. Accompagne les entreprises dans leur visibilité sur les moteurs de recherche.

Articles recommandés

Comment améliorer l'indexation de son site ?

Un site non indexé par Google n’a aucun intérêt. Il n’est pas visible dans les résultats de recherche et, il ne génère aucun trafic organique. Votre site est considéré comme inexistant sur le web. En rédigeant cet article, nous avons souhaité vous donner la solution pour : Pour bien comprendre les fonctions de l’indexation d’une [...]

Redirections SEO : Guide pratique

Qu'est-ce qu'une redirection ? Les redirections SEO sont des solutions techniques pour garantir l’affichage du contenu pour les utilisateurs et pour les moteurs de recherche, lorsqu’il y a des modifications apportées sur le site. Le site web conserve ainsi son optimisation et ses performances. Indispensables, les redirections permettent une gestion simple et efficace des pages [...]

Negative SEO : Comprendre, détecter et se protéger d’une attaque SEO malveillante

Vous avez bossé vos contenus, affûté vos backlinks, optimisé votre site… et pourtant, vos positions chutent sans raison apparente ? Bienvenue dans l’univers discret mais redoutable du Negative SEO. Loin d’être un mythe, le SEO négatif désigne l’ensemble des pratiques malveillantes utilisées pour nuire au référencement d’un site concurrent. Liens toxiques, vol de contenu, faux [...]