Negative SEO : Comprendre, détecter et se protéger d’une attaque SEO malveillante

Vous avez bossé vos contenus, affûté vos backlinksLien provenant d'un site externe pointant vers votre site. Facteur de ranking majeur., optimisé votre site… et pourtant, vos positions chutent sans raison apparente ? Bienvenue dans l’univers discret mais redoutable du Negative SEOPratique malveillante visant à nuire au référencement d'un concurrent..

Loin d’être un mythe, le SEO négatif désigne l’ensemble des pratiques malveillantes utilisées pour nuire au référencement d’un site concurrent. Liens toxiquesBacklink de mauvaise qualité pouvant nuire au référencement (spam, PBN, sites pénalisés)., vol de contenu, faux avis, piratage... Ce n’est pas vous qui faites du black hatTechniques SEO contraires aux guidelines Google, risquant des pénalités. — c’est vous qui le subissez.

Le pire ? Ça peut passer totalement inaperçu... jusqu’à ce que Google vous pénalise.

Dans cet article, on va :

- définir clairement ce qu’est le Negative SEO,

- passer en revue les attaques les plus fréquentes,

- voir comment les détecter (avant qu’il ne soit trop tard),

- et surtout, apprendre à s’en protéger intelligemment.

Le Negative SEO, c’est quoi exactement ?

Qu’est-ce que le Negative SEO (NSEO) ?

Le Negative SEO (ou SEO négatif), c’est l’art de saboter le référencement d’un site web tiers, en jouant contre les règles de Google. On parle ici d'attaques volontaires, malveillantes et souvent anonymes.

Ce n’est pas une erreur d’optimisation de votre part : c’est un concurrent (ou un script) qui tente de vous faire passer pour un tricheur auprès de Google. Et ça peut fonctionner.

Pourquoi est-ce un vrai problème en 2025 ?

Google affirme que ses algorithmesProgramme informatique utilisé par les moteurs de recherche pour classer les pages web. Google utilise plus de 200 facteurs de ranking. sont suffisamment “intelligents” pour ignorer les liens spammy ou les signaux artificiels. En théorie.

Mais en pratique, les attaques ont évolué. Aujourd’hui, les assauts ne se limitent plus à du simple link spam. Ils visent aussi :

- la réputation (via des faux avis),

- la sécurité (piratage, DDoS),

- et même les procédures légales (plaintes DMCA bidons).

Résultat : des pertes de positions, une baisse de trafic organiqueVisites provenant des résultats de recherche naturels (non payants) des moteurs de recherche., une réputation écornée… et parfois, une pénalité manuelle.

Le point de vue (pas toujours rassurant) de Google

Google, via ses porte-paroles, continue de dire qu’il « sait faire la différence ». Mais les retours du terrain racontent autre chose.

Quand votre trafic plonge sans raison, que des liens russes pointent vers vos pages, ou que vos contenus sont copiés sur 40 sites inconnus… difficile de ne pas s’inquiéter.

Conclusion ? Mieux vaut prévenir que guérir. Et surtout, mieux vaut comprendre les règles du jeu que de les subir.

Les techniques les plus utilisées en Negative SEO

Le SEO négatif, ce n’est pas un seul type d’attaque. C’est tout un arsenal. Certaines techniques sont grossières, d’autres ultra subtiles. Mais toutes ont le même objectif : faire chuter vos positions.

1. Spam de liens à grande échelle

C’est la plus connue. L’attaquant balance des milliers de backlinks pourris (forums douteux, annuaires spammy, blogs en ruine) vers votre site, souvent en mode automatisé.

👉 Objectif : faire croire à Google que vous achetez des liens toxiques pour tricher.

Résultat : soit une pénalité manuelle, soit une dévaluation algorithmique. Dans les deux cas : votre profil de liens prend cher.

2. Ancres suroptimisées (anchor text)

Encore plus vicieux : répéter à outrance le même mot-clé sur des liens douteux (“chaussures pas chères”, “acheter iphone reconditionné”...).

👉 Google déteste les profils d’ancres trop “parfaits”. C’est un signal fort de manipulation.

Une attaque bien orchestrée peut cibler vos pages stratégiques et les rendre suspectes à l’œil de Google.

3. Redirections toxiques

L’attaquant récupère des vieux domaines pénalisés ou spammés, puis les redirige vers votre site.

👉 L’effet ? Vous récupérez leur “karma pourri”. Et Google peut associer votre site à une mauvaise réputation sans que vous ne vous en rendiez compte.

4. Vol de contenu (content scraping)

Votre contenu est bon ? Il va être copié.

Certains attaquants automatisent le vol de contenu et le republient avant vous, parfois sur des sites plus puissants. Résultat : c’est eux qui ressortent en top des SERP, pas vous.

👉 Google pense alors que c’est vous le plagiaire. Gênant, non ?

5. Faux avis et campagnes de dénigrement

On entre ici dans l’e-réputation.

Des dizaines d’avis 1 étoile qui débarquent sur votre fiche GoogleFiche d'établissement Google affichant les informations locales d'une entreprise., Trustpilot ou Yelp… et qui ne parlent jamais vraiment de vos services ? C’est louche.

👉 En local ou en B2C, quelques faux avis peuvent détruire la confiance client. Et Google, qui s’appuie sur les signaux d’engagement, peut vous faire descendre aussi.

6. Piratage et injection de spam

Un WordPress non à jour, un plugin douteux… et boum : votre site est infecté.

L’attaquant peut injecter :

- des liens cachés,

- du spam pharma,

- des redirections vers des sites X...

👉 Si Google détecte ça, il peut afficher “Ce site peut endommager votre ordinateur” dans les résultats. C’est la mort du trafic.

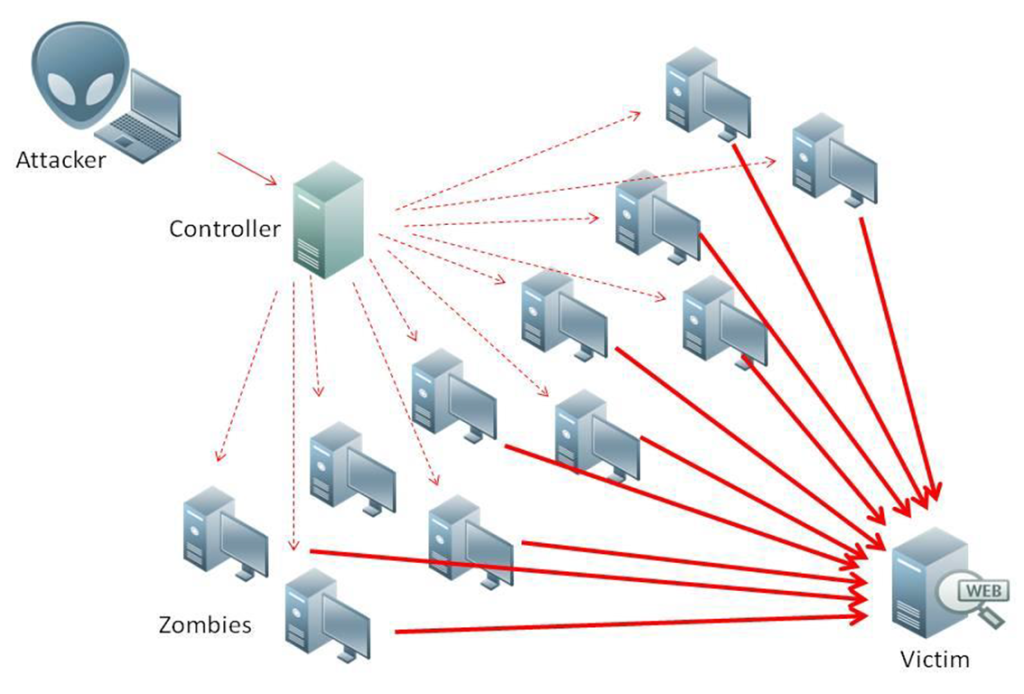

7. Attaques DDoS et hotlinking

Plus sournois : faire planter votre site ou le ralentir jusqu’à le rendre inutilisable.

- DDoS = bombardement de requêtes serveur

- Hotlinking = charger vos images depuis un autre site, en pompant votre bande passante

👉 Site lent ou down = explorationProcessus par lequel les robots des moteurs de recherche parcourent et analysent les pages web. impossible pour GooglebotRobot d'exploration de Google qui parcourt le web pour découvrir et indexer les pages. = perte d’indexationProcessus par lequel Google ajoute une page à sa base de données pour qu'elle puisse apparaître dans les résultats. et de visibilité.

8. Fichiers critiques manipulés (robots.txt, .htaccess)

Si l’attaquant accède à votre serveur ou FTP, il peut :

- bloquer volontairement l’exploration de certaines pages,

- rediriger vos URLs vers de mauvaises destinations

👉 Vous perdez le contrôle de ce que voit Google.

9. Faux retraits de liens (link removal scam)

Encore plus pervers : l’attaquant se fait passer pour vous ou votre agence SEO… et demande à des sites de qualité de supprimer vos backlinks.

👉 Moins de liens = moins d’autorité = baisse des positions.

Et bien sûr, vous ne recevez jamais d’alerte.

10. Plaintes DMCA frauduleuses

Une plainte DMCA = demande de suppression pour contenu plagié.

Sauf que parfois… c’est le voleur qui accuse le créateur original.

👉 Google peut désindexer votre page, ou supprimer des backlinks légitimes. Oui, c’est aussi absurde que réel.

Comment repérer une attaque de Negative SEO ?

Le vrai danger du SEO négatif ? C’est souvent silencieux.

Pas de pop-up d’alerte. Pas de sirène rouge. Juste un site qui commence à perdre du trafic… puis des positions… puis des clients.

Alors comment savoir si quelqu’un essaie de plomber votre référencement ? Voici les signes à surveiller — et les bons réflexes à adopter.

Chute soudaine de trafic ou de positions

C’est souvent le premier signal. Vous perdez 30, 50, voire 70 % de trafic organique sans mise à jour Google connue ni changement côté site ? Suspicion immédiate.

Outils à utiliser :

- Google AnalyticsOutil gratuit Google pour analyser le trafic et le comportement des visiteurs d'un site. : comparez vos sessions organiques sur 30 / 60 jours.

- Outils de suivi de positions : SEMrush, Ahrefs, SE RankingPosition d'une page web dans les résultats de recherche pour une requête donnée.…

Si plusieurs mots-clésTerme ou expression que les utilisateurs saisissent dans un moteur de recherche. Base de toute stratégie SEO. chutent d’un coup, surtout ceux qui ramenaient du trafic, il faut creuser.

Alertes dans Google Search Console

La GSC est votre première ligne de défense. Connectez-vous souvent, ou mettez des alertes mail.

À surveiller :

- Actions manuelles : “liens non naturels”, “contenu de faible qualité”, etc.

- Problèmes de sécurité : malware détecté, piratage, pages spammées

- Pages bloquées / non indexées : robots.txtFichier texte à la racine d'un site indiquant aux robots quelles pages explorer ou ignorer. ou .htaccess modifié sans raison ? Alerte.

Ne laissez jamais ces alertes dormir plus de 24h.

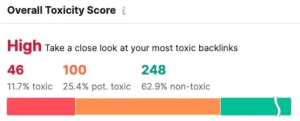

Pic anormal de backlinks (souvent de mauvaise qualité)

Un afflux massif de liens venus de nulle part ? Forums russes, sites X, domaines .xyz ou .cn… Tous pointent vers vous, souvent sur une seule page, avec des ancres douteuses ?

Clairement pas naturel.

À faire :

- Vérifiez votre profil de liens avec Ahrefs / MajesticOutil spécialisé dans l'analyse des backlinks avec les métriques Trust Flow et Citation Flow. / SEMrush

- Triez par date d’acquisition et score de qualité

- Cherchez des ancres suroptimisées ou un volume anormal sur une page

Ce n’est pas le moment de paniquer, mais de documenter. (Et de surveiller si ça s’intensifie.)

Votre contenu retrouvé… ailleurs

Vous publiez un bel article. Trois jours plus tard, vous le retrouvez sur 12 sites différents.

Si Google indexe leur version avant la vôtre, vous pouvez être pénalisé pour “contenu dupliqué”.

Outils à utiliser :

- Copyscape

- Siteliner

- Google (recherche avec des extraits entre guillemets)

Astuce : mettez toujours une date de publication claire et indexez vos contenus vite via GSC (Inspecter l’URL → Indexer).

Site qui rame ou ne charge plus

- Temps de chargement qui explose ?

- Erreurs 5xx ou 504 fréquentes ?

- Des pics de trafic sans visiteurs “réels” ?

Possible attaque DDoS ou hotlinking massif.

À checker :

- Votre outil de monitoring serveur (Pingdom, Uptime Robot…)

- Google Search ConsoleOutil gratuit Google pour surveiller et optimiser la présence d'un site dans les résultats de recherche. : erreurs d’exploration / crawl budgetNombre de pages que Googlebot peut et veut crawler sur un site dans un temps donné.

- Logs serveurFichiers enregistrant toutes les requêtes reçues par un serveur, permettant d'analyser le comportement des bots. (si vous avez un admin ou un hébergeur qui suit)

Un site lent, c’est une UX décevante, et Google n’aime pas ça.

En résumé :

| Symptôme | Cause possible | Réaction immédiate |

| Chute de trafic brutale | Spam de liens, piratage, faux avis | Comparer dans GSC / GA, chercher les pics |

| Alertes GSC (sécurité, actions manuelles) | Attaque avérée, Google a réagi | Auditer + plan d’action |

| Backlinks douteux en masse | Link bombing / anchor textTexte cliquable d'un lien hypertexte. Doit être descriptif et pertinent. toxique | Export, qualifier, surveiller |

| Contenu dupliqué détecté | Content scraping | Documenter, envoyer une plainte DMCA |

| Site lent ou inaccessible | DDoS, hotlinking, bots | Contacter l’hébergeur, protéger l’accès |

Outils pour détecter et analyser une attaque

Les signaux d’alerte, c’est bien. Mais pour confirmer une attaque de Negative SEO, il faut des outils. Pas besoin d’un budget infini, mais un minimum d’arsenal est indispensable.

Voici les incontournables à avoir dans sa boîte à outils (et comment les utiliser).

Google Search Console (GSC) :le réflexe numéro 1

C’est gratuit. C’est fiable. Et c’est la source officielle de Google.

À surveiller :

- Actions manuelles (onglet "Sécurité et actions manuelles")

- Rapport sur les liens : attention aux nouveaux domaines suspects

- Erreurs de couverture / sécurité

- Pages exclues de l’indexation sans raison apparente

Google Analytics pour détecter les anomalies de trafic

Votre trafic organique fait une chute libre un mardi à 15h ? C’est là que GA entre en scène.

À suivre :

- Canal “organic” → vérifiez les sessions, taux de rebondPourcentage de visiteurs quittant un site après avoir vu une seule page., durée moyenne

- Pages de destination : une page chute brutalement ? Cible probable.

- Sources de trafic douteuses (referral spam, botnet, etc.)

Bonus : créez des alertes personnalisées pour recevoir un mail si le trafic baisse de plus de X % d’un jour à l’autre.

Ahrefs / SEMrush / Majestic pour analyser votre profil de backlinks

Les outils payants, mais indispensables si vous gérez un site sérieux.

Utilisation :

- Historique des backlinks : surveillez les pics

- Qualité des domaines référentsSite web distinct envoyant au moins un backlink vers votre site. (DR, Trust FlowMétrique Majestic mesurant la qualité et la fiabilité des backlinks d'un site.…)

- Ancres optimisées ou spammy

- Langue / thématique / pays non cohérents avec votre cible

Objectif : isoler les liens toxiques avant qu’ils ne fassent mal.

Copyscape / Siteliner pour traquer les copieurs

Vous pensez qu’on a piqué votre contenu ? Vérifiez vite.

- Copyscape : détecte les pages dupliquées ailleurs sur le web.

- Siteliner : scanne votre propre site pour repérer les duplications internes ou externes.

Si le contenu dupliqué vous précède dans l’index de Google, vous perdez la priorité.

Google Alerts / Mention pour surveiller votre marque

Configurez des alertes sur :

- le nom de ton entreprise,

- les produits phares,

- les responsables / dirigeants.

Vous saurez si quelqu’un parle de vous sur un blog obscur, dans un commentaire douteux ou via un faux avis Google.

Ces outils sont aussi utiles pour repérer les campagnes de dénigrement (avis, forums, fausses interviews…).

Option bonus : outils serveurs / sécurité

Si vous êtes un peu plus tech (ou avez un hébergeur réactif), pensez à :

- Uptime Robot ou Pingdom pour surveiller la disponibilité du site

- Analyse des logs serveur pour repérer des crawls agressifs ou des requêtes suspectes

- Cloudflare / Sucuri pour bloquer les attaques DDoS ou les tentatives de piratage

Comment se protéger (vraiment) contre le SEO négatif

Le meilleur moyen de contrer une attaque de Negative SEO ? L’empêcher d’être efficace.

La prévention vaut mieux que la réaction. Voici les piliers d’une stratégie de défense robuste — technique, stratégique et durable.

Sécuriser l’infrastructure du site

Un site vulnérable est une cible facile. C’est la base.

À mettre en place sans attendre :

- HTTPS activé (avec certificat SSLProtocole sécurisé de transfert de données. Facteur de ranking depuis 2014. à jour)

- Mots de passe forts et authentification à deux facteurs (2FA)

- Mises à jour régulières du CMS, des plugins et thèmes (surtout sous WordPress)

- Pare-feu applicatif (WAF) via Cloudflare, Sucuri ou autre

- Sauvegardes automatiques et fréquentes (locales et cloud)

Objectif : empêcher toute intrusion (injection de code, modification de fichiers sensibles, redirections, etc.).

Construire un profil de liens sain (et naturel)

Un site bien “linké”, avec un profil propre et diversifié, résiste mieux aux attaques par backlinks toxiques.

Les bonnes pratiques à renforcer :

- Obtenir régulièrement des liens éditoriaux de qualité

- Diversifier les sources (presse, blogs, annuaires pros, partenaires…)

- Varier les ancres (marque, URL, génériques, mots-clés longue traîneExpressions de recherche longues et spécifiques (3+ mots) avec moins de volume mais un meilleur taux de conversion.)

- Suivre l’évolution de son netlinking via Ahrefs / SEMrush / GSC

Plus votre profil est cohérent et robuste, plus les signaux négatifs externes apparaîtront comme des anomalies isolées… que Google ignorera plus facilement.

Miser sur l’E-E-A-T et des contenus de qualité

Le SEO de 2025 ne repose plus uniquement sur des optimisations techniques. Google valorise avant tout l’expérience utilisateurUser Experience. Qualité de l'expérience vécue par un utilisateur sur un site. Facteur de ranking indirect., l’expertise et la fiabilité.

Concrètement :

- Créer du contenu profond, précis, à forte valeur ajoutée

- Mettre en avant l’auteur, son expertise, ses références

- Travailler la confiance (mentions légales, politique de confidentialité, avis clientsÉvaluations laissées par les clients sur Google Business Profile. Facteur de ranking local. vérifiés…)

- Maintenir une cohérence éditoriale et UX sur toutes les pages

Un site reconnu pour sa qualité globale aura plus de résilience face à une attaque réputationnelle, à du contenu dupliqué ou à une sur-optimisation forcée.

Mettre en place une veille continue

Protéger un site, ce n’est pas cocher une checklist une fois pour toutes. C’est surveiller activement ce qui s’y passe, au quotidien.

À intégrer dans votre routine SEO :

- Audit backlinks mensuel

- Check Google Search Console 1 à 2 fois par semaine

- Vérification régulière du contenu dupliqué (Copyscape, Siteliner…)

- Alertes Google pour les mentions de votre marque

- Suivi de la performance serveur et de la disponibilité

Astuce : documentez vos indicateurs de référence (trafic organique moyen, vitesse de chargement, rythme d’acquisition de liensStratégie d'acquisition de backlinks de qualité pour renforcer l'autorité d'un site., etc.). Cela permet de détecter plus facilement une anomalie.

Que faire en cas d’attaque ? (Plan d’action)

Une attaque est en cours ? Pas de panique.

Voici la feuille de route à suivre pour réagir vite, éviter les dégâts et reprendre le contrôle.

1. Diagnostiquer calmement, mais rapidement

Avant de passer à l’action, il faut confirmer le diagnostic.

Checklist express :

- Chute de trafic ou de position détectée dans GSC / Analytics

- Profil de backlinksEnsemble des caractéristiques des backlinks d'un site : quantité, qualité, diversité, ancres. anormal (volume, qualité, ancres)

- Alertes de sécurité ou d’actions manuelles dans la Search Console

- Contenu dupliqué ou avis suspects identifiés

Objectif : valider qu’il ne s’agit ni d’une simple mise à jour Google, ni d’une erreur technique interne.

2. Désavouer les backlinks toxiques (si nécessaire)

L’outil de désaveu de Google n’est pas à utiliser à la légère. Mais en cas de spam massif, il peut être utile.

Quand agir :

- S’il y a une action manuellePénalité appliquée manuellement par un employé Google pour violation des guidelines. pour liens non naturels

- Ou si une chute brutale de trafic coïncide avec un afflux de liens toxiques

À faire :

- Exporter les liens douteux via Ahrefs / GSC

- Créer un fichier .txt avec domain:nomdedomaine.com par ligne

- Le soumettre via l’outil officiel : https://search.google.com/search-console/disavow-links

⚠️ Ne désavouez jamais à l’aveugle. Un lien médiocre n’est pas forcément nocif.

3. Réagir aux faux avis et au dénigrement

Une campagne de dénigrement est souvent silencieuse… mais dévastatrice.

Votre mission :

- Identifier et signaler chaque faux avis sur Google, Yelp, Trustpilot, etc.

- Répondre publiquement de manière professionnelle, factuelle

- Encourager vos vrais clients à publier des avis positifs pour noyer les faux

🎯 Une réputation en ligne, ça se construit. Et ça se défend, avis après avis.

4. Protéger votre contenu volé (scraping)

Si votre contenu a été copié :

- Contactez les webmasters des sites plagiaires

- Si pas de réponse : contactez les hébergeurs

- Puis, en dernier recours : déposez une plainte DMCA auprès de Google

→ Formulaire DMCA officiel

Astuce : pour éviter que le duplicate vous pénalise, pensez à indexer rapidement vos contenus originaux (via GSC → Inspection d’URL).

5. Nettoyer après un piratage ou une attaque technique

Site piraté ? Voici les étapes clés :

- Coupez temporairement l’accès si nécessaire (maintenance)

- Changez tous les accès (FTP, CMS, DB…)

- Supprimez tout code malveillant

- Restaurez une version saine à partir d’une sauvegarde

- Demandez un réexamen via GSC si Google a affiché une alerte de sécurité

H2 En cas d’attaque : 3 réflexes

- Observer sans paniquer : toute baisse n’est pas forcément un sabotage.

- Agir méthodiquement : pas de précipitation, chaque action compte.

- Renforcer la prévention ensuite : l’objectif n’est pas juste de réparer, mais d’éviter la prochaine attaque.

SEO négatif & intelligence artificielle : quel futur ?

Le SEO négatif évolue. Et comme tout dans le digital, l’intelligence artificielle y joue déjà un rôle croissant — des deux côtés du champ de bataille.

On pourrait croire que l’IA va simplement renforcer les défenses. C’est partiellement vrai. Mais elle donne aussi des moyens inédits… aux attaquants.

L’IA, nouvelle arme du sabotage ?

Avant, une attaque de Negative SEO demandait des outils automatisés, un peu de technique, et du temps. Aujourd’hui, l’IA générative change la donne. Elle permet de scaler des attaques autrefois artisanales, de façon rapide et “propre”.

Par exemple :

- Générer des milliers de faux avis crédibles en quelques minutes, avec un langage naturel, difficilement détectable.

- Réécrire du contenu volé avec un bon niveau de reformulation, suffisant pour tromper les outils anti-plagiat classiques.

- Automatiser l’analyse de profils de backlinks d’un concurrent… pour mieux cibler ses pages stratégiques.

L’IA, levier de défense pour les sites solides

Heureusement, l’intelligence artificielle n’est pas qu’un outil offensif. Bien utilisée, elle permet de mieux anticiper les risques, et d’améliorer la résilience globale d’un site.

Des outils basés sur l’IA peuvent :

- Détecter des anomalies comportementales (trafic, backlinks, vitesse serveur…) bien avant qu’un humain ne s’en rende compte.

- Analyser de grandes quantités de données (logs, crawls, signaux off-page) pour identifier des patterns anormaux, typiques d’une attaque.

- Aider à produire du contenu optimisé, cohérent avec l’intention de rechercheObjectif réel de l'utilisateur derrière sa requête : informationnelle, navigationnelle, transactionnelle ou commerciale., et renforçant l’E-E-A-T.

Autrement dit : l’IA, côté SEO “défensif”, devient une aide à la prise de décision rapide. Ce n’est pas une solution miracle, mais c’est un outil de veille et de réactivité précieux.

À retenir :

- Le Negative SEO s’est professionnalisé : aujourd’hui, il ne se limite plus aux liens toxiques.

- Google ne prévient pas toujours — il faut donc surveiller proactivement son site.

- Une sécurité technique robuste, un profil de liens maîtrisé et une stratégie de contenu qualitative sont vos meilleurs alliés.

- Face aux attaques complexes, une réaction rapide et documentée permet souvent de limiter les dégâts.

- Enfin, un site qui inspire confiance, qui apporte de la valeur, et qui bénéficie de signaux utilisateurs réels est, à terme, plus difficile à affaiblir par des moyens artificiels.

Tags

SEO Consultant

Pierre-Antoine est consultant SEO chez Slashr. Il met son expertise au service des entreprises pour améliorer leur positionnement et leur trafic organique.

Voir tous ses articlesArticles recommandés

Cannibalisation SEO : quand vos pages se tirent dans les pattes

Vous avez bossé votre SEO, publié du contenu régulièrement, optimisé vos mots-clés… mais le référencement de votre site ne décolle pas comme prévu ?Et si le problème venait… de vos propres pages ? La cannibalisation SEO, c’est ce phénomène (pas si rare sur le web) où plusieurs pages d’un même site se battent pour la même requête.Résultat [...]

L’arborescence SEO : la structure que Google (et vos visiteurs) attendent de vous

Vous avez bossé vos mots-clés, publié du contenu de qualité, peaufiné vos balises… et pourtant, votre site ne décolle pas ? Et si le vrai problème, c’était… l’ossature même de votre site ? L’arborescence, c’est cette structure souvent invisible à l’œil nu, mais qui conditionne absolument tout : le référencement naturel, l’expérience de navigation, le [...]

Analyse SEO concurrentielle : décortiquez vos rivaux mot-clé par mot-clé

👟 Le SEO, c’est comme le trail : si vous partez sans repérer le terrain, vous finissez dans le fossé. Avant d’écrire le moindre mot, avant de lancer une ligne de code, avant même de réfléchir à une stratégie de contenu… vous devez savoir qui occupe déjà la SERP et pourquoi. Ce n’est pas une [...]